Al hilo del debate sobre la evaluación on-line iniciado ayer en el blog, publicamos hoy sábado este interesante ejercicio empírico fruto de la inquietud del autor y que, aunque muy preliminar y parcial, seguro que también despierta la curiosidad del lector y deja algunas pistas para futuras investigaciones.

A raíz de leer el interesante y “challenging” artículo de Javier Ferri en NeG sobre las posibles consecuencias que puede tener la evaluación on-line en nuestros estudiantes universitarios en tiempos de covid19, he pensado que mi docencia actual, en plena crisis sanitaria, me da la oportunidad de poder comparar para un grupo de alumnos de la Universidad de Barcelona el resultado de realizar un mismo test (36 preguntas exactamente iguales), en el mismo soporte (móvil o portátil), en el mismo marco de evaluación (evaluación continuada con el mismo peso en la nota final) pero en dos escenarios distintos: con los estudiantes presentes en el aula como parte de un aprendizaje de “aula invertida” que llevé a cabo el curso pasado o con los estudiantes on-line dado el impacto del covid19 en la docencia universitaria de este segundo cuatrimestre del curso 2019-2020.

Evidentemente, lo que sigue es el resultado de mi curiosidad y de un Primer de Mayo “trabajando”, y son simples estadísticas descriptivas para un grupo de universitarios cursando la mayoría de ellos tercero de grado pero que he pensado pueden ser interesantes a raíz de la entrada de Javier Ferri. ¿A quién puede perjudicar o beneficiar la evaluación on-line? (evidentemente no me pregunto los posibles “por qué” pues no los puedo contestar).

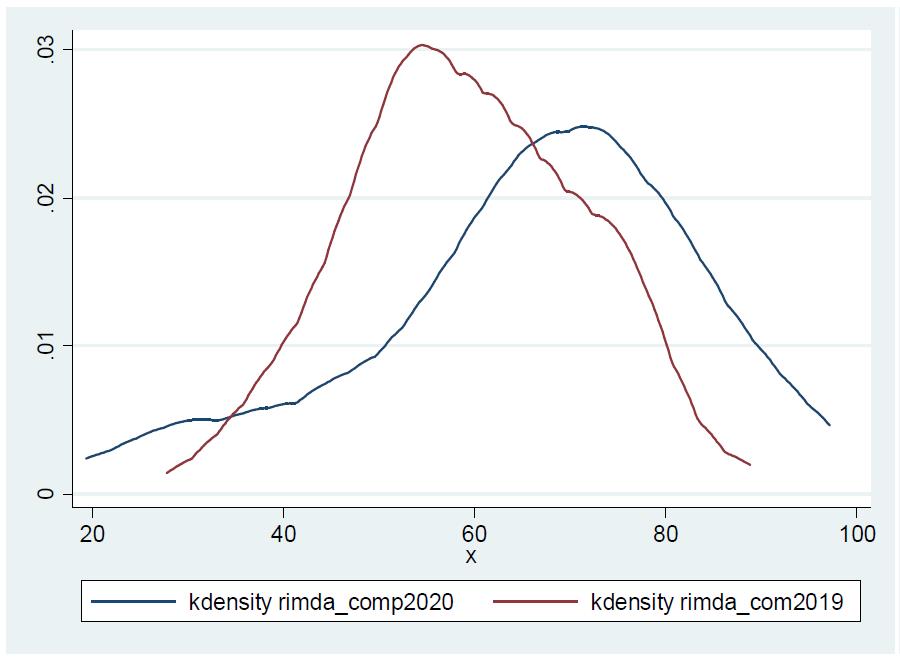

Así pues, a continuación os muestro los resultados de un mismo test realizado en 2019 y 2020 por diferentes estudiantes (la mayoría de ellos) y para los cuales no se puede inferir nada al respecto del esfuerzo ejercido o de las posible acciones de “cheating” que hayan podido implementar, antes y, sobretodo, en la actual situación no presencial. Pero en todo caso creo que el ejercicio puede ser informativo. Los resultados globales son:

TODOS LOS ALUMNOS

Estos resultados globales para los dos escenarios nos dirían que entre el año pasado (presencial) y este (on-line) los estudiantes sacan en promedio mejores notas al realizar el mismo test de conocimientos. Vale la pena destacar que si en algún escenario hay más presión del tiempo ha sido en la realización del test on-line, pues los 50 minutos que les di fueron más estrictos que los que tuvieron al realizar la prueba presencial.

Pero, evidentemente, entre todos los alumnos que han realizado el test el año pasado y este año hay claramente dos grupos de alumnos:

A) los alumnos que se matriculan por primera al curso y que han visto sólo una vez el cuestionario, sea el año pasado (y aprobaron el curso) o este año.

B) los que hicieron el cuestionario el año pasado y también este, es decir, los repetidores.

Obviamente los dos grupos son distintos en muchas dimensiones, y tampoco podremos saber si esas diferencias les han condicionado el esfuerzo realizado, o cómo han realizado el test (si se han comunicado más entre ellos, o alguien les ha ayudado de alguna manera). En todo caso lo que podemos hacer es ver qué dicen los resultados de comparar ambos grupos. La descriptiva básica de los resultados para el primer grupo de alumnos arroja unos resultados muy similares para los estudiantes de ambos cursos (presenciales vs on-line), de hecho, el test de medias nos dice que las dos distribuciones de resultados no son significativamente distintas entre ellas, al menos teniendo en cuenta la media y la desviación de las notas obtenidas en el test. En todo caso los resultados de los alumnos on-line muestra una mayor dispersión.

TEST POR PRIMERA VEZ

La diferencia en los resultados del test observada para el conjunto de alumnos viene determinada por los estudiantes repetidores, es decir, los que tienen más experiencia en el test ya que lo vieron el año pasado.

REPETIDORES

Este grupo de estudiantes son los que realmente han mejorado sus resultados como consecuencia de hacer el test on-line, y lo han hecho, en promedio, de forma significativa.

Evidentemente este grupo de estudiantes (en azul en el siguiente gráfico) tiene más experiencia, quizás más presión por aprobar la asignatura pero a su vez fueron los estudiantes que tuvieron unos peores resultados en el conjunto de la evaluación del curso pasado, no sólo en el test que formaba parte de la evaluación continua sino en el conjunto de la asignatura, pues acabaron suspendiendo y se volvieron a matricular a la asignatura.

Así pues, en el debate del impacto de la evaluación on-line vs la presencial o vs la no-evaluación (opción puesta sobre la mesa por Javier Ferri) los resultados en el caso de mi asignatura me indican que para los “nuevos” estudiantes del curso, que varían entre los dos cursos y evidentemente pueden tener muchas características intrínsecas que les condicionen su empeño y, por tanto, sus resultados, en promedio el realizar el test on-line desde casa no les afecta a sus resultados; al contrario... la distribución de notas parece desplazarse hacia la derecha, con unas notas más altas (y un poco más dispersas). Quizás los buenos estudiantes se pueden beneficiar de un contexto más tranquilo para desarrollar su actividad de aprendizaje y para rendir en las pruebas. Dónde si observo un cambio más importante es en los estudiantes repetidores, los que ya hicieron el test el curso el año pasado pero les fue mal y parece que este año o se han puesto las pilas y han estudiado, o tienen muy buena memoria o han encontrado un forma de realizar el test que les ha ido mucho mejor. Para ellos creo que tengo que probar con un test completamente diferente para ir descartando alternativas.

Hay 7 comentarios

Muy ineresante, gracias por aportar al debate. Pero sigue sin resolver algunas dudas relevantes:

¿se copia más en un examen online que en uno presencial? y ¿copiarán los universitarios españoles más online de lo que hacían presencialmente, por tener más oportunidades?

Disculpas por calzarme en los zapatos del reviewer #2, pero no resuelve si la mejor la mejor nota de los repetidores (5.2 vs 6.7) se debe al contexto (online vs presencial) o la mejora de los repetidores (cuál es la mejora de los repetidores en test presencial el segundo año) o mayor tiempo confinamiento (no controlable).

Las preguntas hiladas con algunas evidencias empíricas aquí:

https://twitter.com/JordiPaniagua/status/1256547168497938432?s=20

y argumentos a favor de la evaluación continua (online y presencial) aquí:

https://alde.es/blog/evaluacion-a-distancia-justa-fiable-eficiente/

Hola Jordi. Gracias por el comentario. Totalmente de acuerdo con tus aportaciones! La idea es abrir el debate a todas las opciones y por supuesto harán falta mejores "empirical strategies" para poder abordar la cuestión con calma y precisión.

Gracias por aportar nueva evidencia para este debate. Me temo, sin embargo, que tus ejercicios no aclaran la cuestión de fondo, y no conducen a un veredicto fiable.

En primer lugar, parece ser que se trata de un test dentro del conjunto de la evaluación continua. No es, por tanto, un examen final en el que los estudiantes se "juegan" la nota de todo el semestre. Un examen final on line anunciado con mucha antelación da tiempo a montar estrategias por parte de los alumnos (y de otros "intermediarios") para el posible fraude, cosa que en los ejercicios que aportas es mucho menos probable.

En segundo lugar, la población no es la misma. No podemos comparar cosas heterogéneas. Es más, en el ejercicio on line hay algunos repetidores que ya conocían las preguntas. En tercer lugar, repetir preguntas del año anterior estimula una actividad de búsqueda que da ventaja a los que descubren el cuestionario. Hay academias y grupos organizados que venden enunciados de examen de años anteriores y las respectivas respuestas. Y anuncian sus servicios en páginas web y listas de anuncios.

Hola José! Gracias por tus comentarios! Evidentemente el ejercicio es meramente descriptivo en todo caso comentarte que mis alumnos se juegan el 50% de la nota final con la evaluación continuada (EC) que está compuesta por cuatro evidencias de evaluación. En general la introducción de la EC ha quitado peso al examen final y a ese concepto de jugarse la nota en un único examen final. Con el cierre de la Facultad, tampoco hubo mucha antelación en la fecha; las primeras semanas fueron de readaptación de contenidos y evaluaciones; yo decidí mantener la EC y hacerla on-line... pero tampoco creo han tenido mucho tiempo como para montar grandes estrategias, aunque sólo les hace falta el whatsapp y poco más para coordinarse entre ellos. Descarto la presencia de "intermediarios" profesionales (quizás si de otros alumnos que les den una mano). Soy consciente que la población no es la misma, pero como digo, en principio me espero que las características que varían entre los dos grupos puedan ser ortogonales a los determinantes del esfuerzo (o del cheating) en uno u otro escenario. Quizás es esperar mucho pero por ahora no tengo otras características de los alumnos para poder controlar por esa heterogeneidad. Dado el soporte del test, en una plataforma educativa, y que el año pasado (primera vez que se llevó a cabo) yo estaba en el aula monitorizando su realización dudo de que lo puedan encontrar en ningún soporte; quizás un pantallazo de alguna pregunta podía correr pero lo dudo mucho.

Pero ¿el cuestionario fue el mismo en las dos convocatorias? Si es así, me temo que no se puede concluir nada ni siquiera tentativamente.

Hola Esteban, las puntuaciones que muestro estan calculadas para las mismas preguntas.

Gracias Daniel por compartir esta información. Para tener más claros los efectos sobre los repetidores, creo que podría ser útil comparar grupos de repetidores en años anteriores (2018 vs 2019 p.e., en caso que tengas esos datos), aislando así el efecto de las diferencias en el aula.

Los comentarios están cerrados.