Escribo esta entrada antes de volar a Denver donde coincidiré con el resto de editores (o no, porque hay tanta gente que no se sabe a quién verá uno). Como Jesús ya les ha contado algo de cómo va esa feria, me ahorra parte de la explicación. Yo voy a entrevistar a jóvenes doctores para ver si convencemos a algunos de los mejores de que se vengan para España. Y, como verán, esta es exactamente una de las cosas que hay que hacer para conseguir una universidad excelente, intentar contratar a los mejores. Porque hoy me interesa volver al asunto que comencé hace un par de semanas, la excelencia en la universidad.

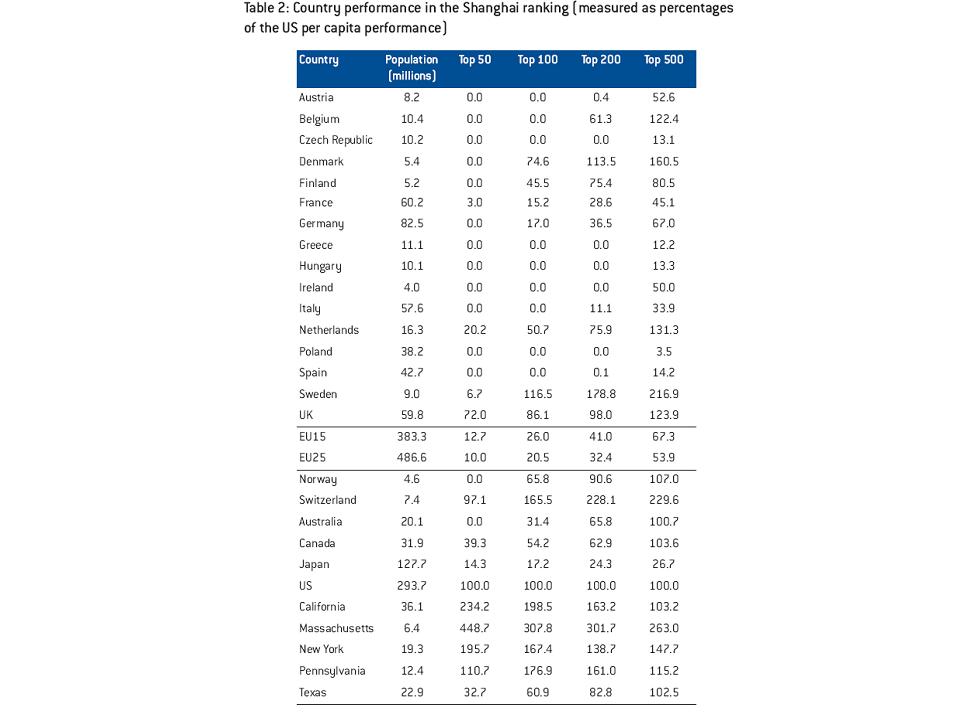

La primera observación importante aquí es que la universidad española, medida en términos generales no presta suficiente atención a la excelencia. Una forma de verlo es la situación que reflejan los famosos rankings de Shanghai. Estos rankings combinan información acerca del número de premios Nobel entre los profesores de una universidad, o que hicieron allí su doctorado, el número de highly cited researchers (investigadores altamente citados, de los que he hablado alguna vez), publicaciones en Science o Nature y publicaciones en revistas indiciadas por el ISI (para más detalles sobre la metodología consultar aquí). Como verán, España no tiene universidades en el ranking hasta la 200.

Un análisis de estos datos, que además busca identificar las causas de los diferentes rendimientos lo han hecho que hicieron un grupo de economistas, inicialmente para Bruegel, un think tank de Bruselas (Philippe Aghion, Mathias Dewatripont, Caroline Hoxby, Andreu Mas-Colell y André Sapir). Los resultados se resumen en un informe de policy de Bruegel ( verlo aquí) y en un artículo de Economic Policy (ver aquí).

Un primer paso en el análisis, que tiene interés per se es cardinalizar el ranking ordinal, es decir, le ponen números. En la lista de las 50 primeras, le dan 50 puntos al primero, 49 al segundo y así sucesivamente. Esto les permite tener medidas per capita por países (es lógico que un país más grande tenga más universidades buenas). Luego estandarizan la puntuación de los Estados Unidos a 100. En esta comparación España también va fatal, pero algunos países (Reino Unido, escadinavos y Holanda) lo hacen relativamente bien una vez ampliamos el ranking más allá de los primeros 100.

Pero lo más interesante es la parte que tiene que ver con los determinantes del éxito relativo. Aquí hay dos tipos de análisis. Uno de puras correlaciones entre naciones, que tiene su interés para sugerir hipótesis, y otro más propiamente causal, que explota variaciones entre los estados americanos.

Los autores enviaron un cuestionario a las universidades para conocer su grado de autonomía y de competencia (para atraer alumnos, profesores y fondos). Las preguntas eran como sigue:

- ¿La universidad establece su propio plan de estudios?

- ¿Puede la universidad seleccionar a sus propios alumnos o hay asignación centralizada?

- ¿En qué medida puede la universidad seleccionar a sus propios profesores?

- ¿Cuánto interviene el estado en la fijación de los salarios?

- ¿Todos los profesores con la misma antigüedad y categoría tienen el mismo salario?

- ¿Debe aprobar el gobierno el presupuesto de la Universidad?

- ¿Qué parte del presupuesto de la universidad proviene de fondos del gobierno?

- ¿Qué parte del presupuesto de la universidad viene de becas de investigación por las cuales la universidad debe competir?

Con estas preguntas se construye un índice de autonomía y competencia. La hipótesis es que cuanta más autonomía y competencia, mejores resultados en los rankings. Los autores dicen que no tiene mucho sentido separar autonomía de competencia. Por un lado porque tienden a ir juntas en casi todas partes, de manera que sería difícil separar sus efectos estadísticamente. Pero además autonomía sin competencia lleva a dilapidar rentas y competencia sin autonomía no permite reaccionar.

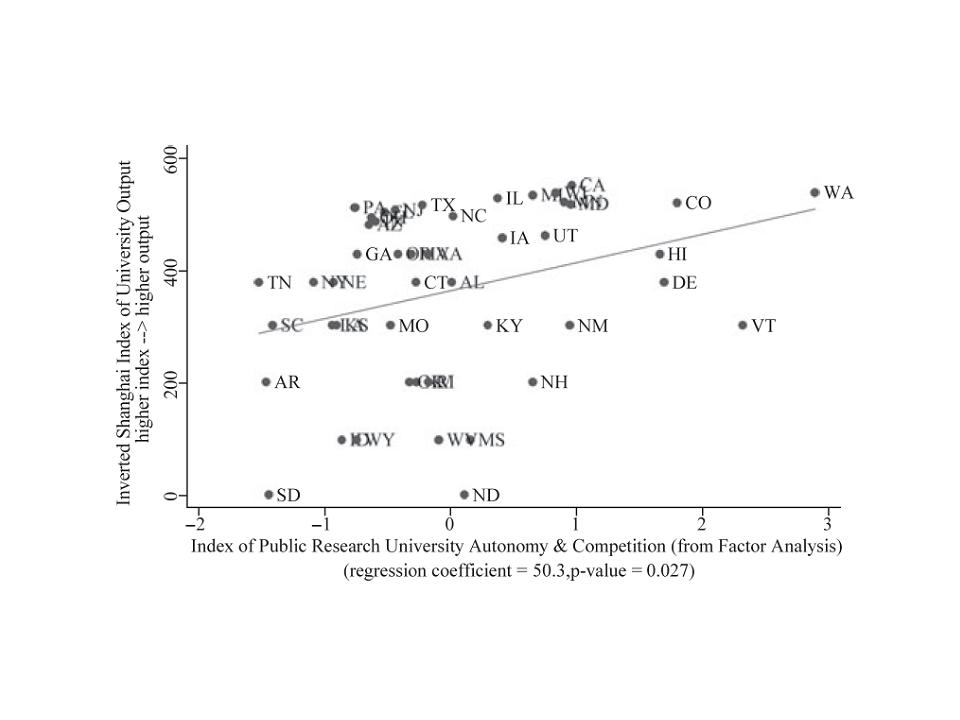

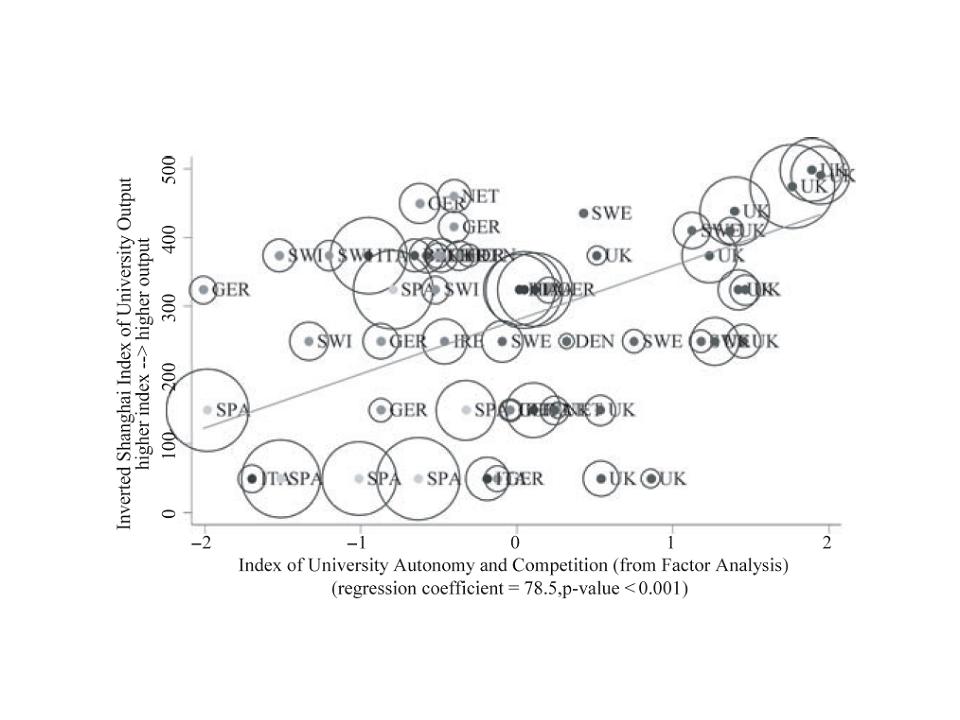

Para ver las correlaciones entre este índice de autonomía y competencia, y los rankings, podemos usar los próximos gráficos (que los autores complementan con análisis de regresión). Los gráficos separan los Estados Unidos de Europa porque índices americanos y europeos de autonomía se calculan de forma diferente. Lo hacen así porque en muchas medidas de autonomía todas las universidades americanas la tienen, y por tanto habría poca variación para ellas.

La conclusión parece clara. Las universidades más autónomas y que se enfrentan a mayor competencia, tienden a tener mejores resultados. Como ya hemos dicho muchas veces, el análisis de correlaciones apunta a un posible culpable, pero no basta para establecer la causalidad que nos interesa (en las películas de juicios dirían que es evidencia circunstancial). La causalidad la buscan los autores en el análisis de cómo las patentes y publicaciones de cada Universidad en Estados Unidos se ven afectadas por la competitividad de los fondos públicos que reciben. Para establecer la causalidad explotan una particularidad del sistema presupuestario americano. Gran parte de los fondos de investigación se gestionan vía convocatorias públicas competitivas, pero un comité del Congreso (el Appropriations Committee) tiene poder para hacer asignaciones bastante arbitrarias (lo que se suele llamar el pork barrel spending.) Dado el poder de este comité, ningún político quiere dejarlo, y solamente eventos aleatorios (una muerte o una jubilación, por ejemplo) crean vacantes. El shock exógeno que les permite analizar la causalidad es el acceso, esencialmente aleatorio argumentan los autores, de un representante del estado al comité, que se traduce en un aumento de financiación no competitiva a las universidades de su estado.

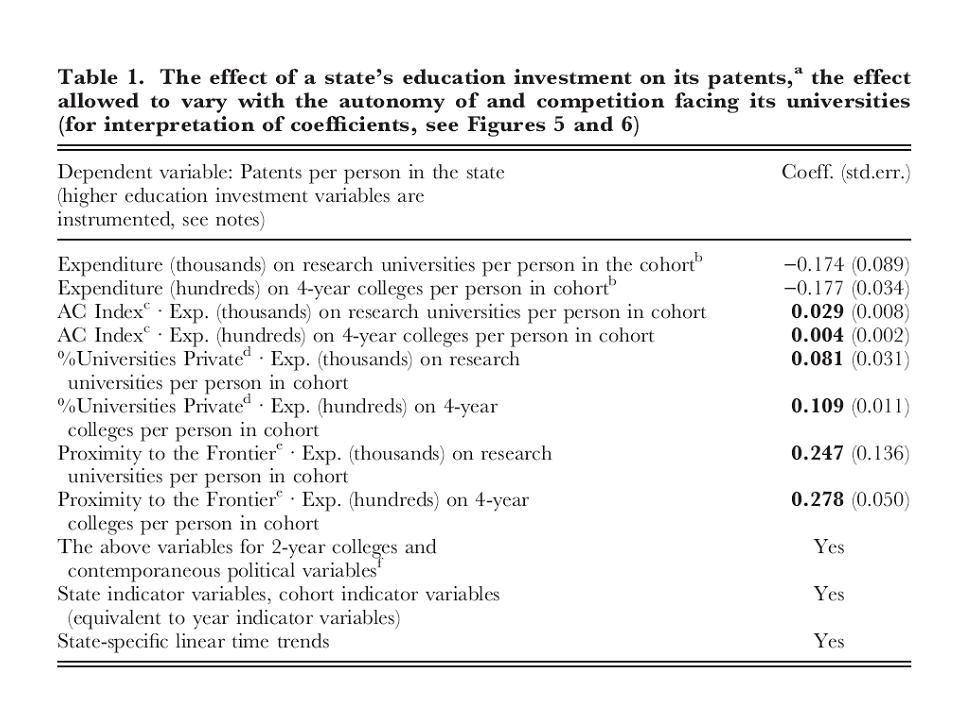

La tabla que sigue mide los efectos de las inversiones en instituciones educativas en el número de patentes. Los dos primeros coeficientes en negrita miden cómo el efecto del dinero gastado aumenta de manera significativa con el índice de autonomía (sobre universidades propiamente de investigación y teaching colleges que enfatizan más el aspecto docente pero donde también se hace investigación). Los dos segundos analizan cómo la presencia de universidades privadas potencia el efecto del gasto en universidades, y el tercero como la cercanía a la frontera tecnológica (donde los retornos a las patentes son mayores) aumenta el efecto del gasto. Los efectos sobre publicaciones son muy parecidos, con la excepción de que disminuye el efecto de la presencia de universidades privadas.

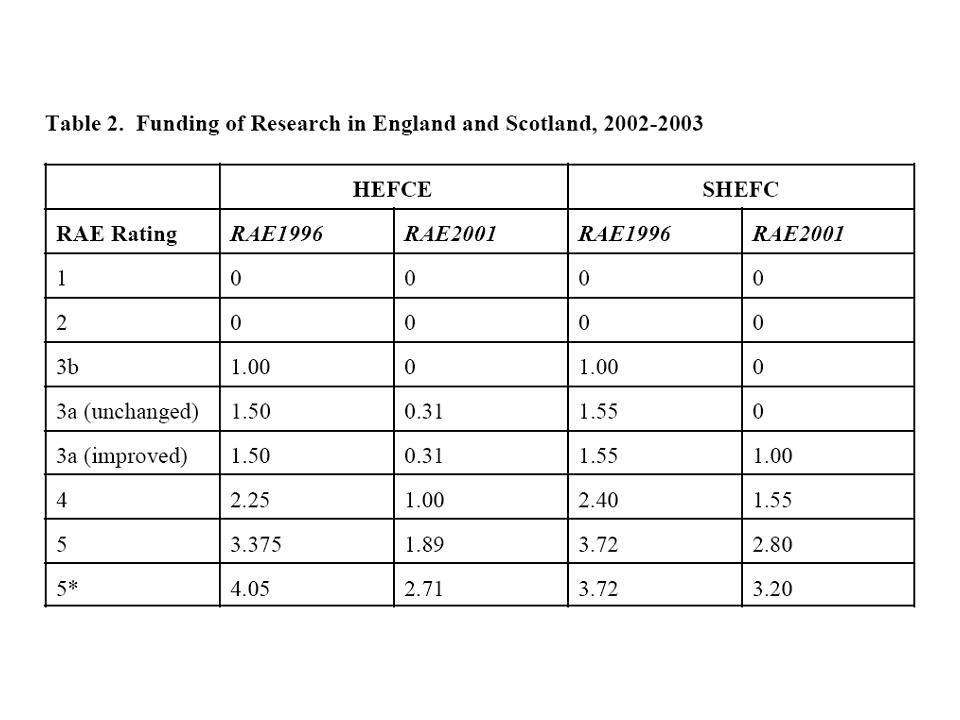

Creo que las conclusiones que podemos sacar son evidentes. Es prioritario aumentar el grado de autonomía y competencia de nuestras universidades. Más flexibilidad contractual y salarial, y más competencia en la provisión de fondos públicos. Un sistema fácilmente copiable es el británico. Cada cuatro o cinco años se hace un research assessment exercise (ejercicio de evaluación de la investigación) en el que se clasifica a las universidades por ramas del saber en categorías (de 5 estrellas a cero estrellas como los hoteles). Y en el período siguiente la financiación de la investigación depende de manera crucial de estos resultados, que los estudiantes también utilizan para saber cuáles son las mejores universidades a las que asistir. Les dejo con un gráfico que ilustra estas diferencias de financiación por número de estrellas para el año 2003 (sacado de aquí). Obviamente, los británicos no dan café para todos (o en su caso, quizá té). Los resultados a la vista están.