En la entrada anterior describí el problema que supone el coste de la suscripción o el acceso a los resultados científicos: bien mediante suscripción pagada por instituciones, bien mediante pago por los autores para hacer accesibles sus trabajos, al final usted acaba pagando por los resultados de una investigación que usted mismo ha financiado. En ese post concluía que era necesaria una acción conjunta de toda la comunidad investigadora, pero que era muy difícil precisamente por la manera en que las editoriales han alcanzado su posición dominante, que es lo que hoy le vengo a contar.

En la entrada anterior describí el problema que supone el coste de la suscripción o el acceso a los resultados científicos: bien mediante suscripción pagada por instituciones, bien mediante pago por los autores para hacer accesibles sus trabajos, al final usted acaba pagando por los resultados de una investigación que usted mismo ha financiado. En ese post concluía que era necesaria una acción conjunta de toda la comunidad investigadora, pero que era muy difícil precisamente por la manera en que las editoriales han alcanzado su posición dominante, que es lo que hoy le vengo a contar.

Hace, digamos, 100 años, decidir si un científico era bueno, muy bueno, malo o regular era bastante fácil. Había pocos, se conocían casi todos entre sí, y seguían las investigaciones unos de otros, con lo cual podían tener una opinión fundada de la valía de cada uno (ya, sí, ya sé que luego la gente es muy mala y puede dejarse llevar por subjetividades, pero olvidémonos de eso por el momento). Hoy en día, esto ya no es así, porque en el mundo hay decenas, centenares de miles de investigadores en activo; algunas estimaciones hablan de un par de millones. Bueno, como sea, pero convendrá conmigo, amigo lector, en que hay muchísimos y que no es posible conocerlos a todos. En algunos campos muy, muy específicos quizá sí, pero en general no. Aquí es cuando surge el problema de cómo evaluar la actividad de los investigadores y, sobre todo, de como seleccionarlos cuando varios optan a un puesto de trabajo.

La solución con la que hemos dado se basa, y aquí está el quid de la cuestión, en las publicaciones. Como no conozco a esas personas, me miro lo que publican a ver si es interesante y si contribuyen realmente al avance del campo. Suena bien, pero no es posible porque simplemente no hay tiempo para hacer esto cuando uno tiene grandes números de solicitantes para un puesto. Así que la primera solución fue hacer una evaluación un poco "de bulto", o "al peso": el que más publica es el mejor, algo que se ha traducido en el famoso slogan "publish or perish" (publica o muere). Espero no necesitar convencerle de que este criterio es bastante malo, por múltiples motivos, pero el principal es que incentiva la publicación de resultados parciales, cuanto más troceaditos mejor, y el dedicarse a problemas facilitos que permitan tener publicaciones rápidamente y seguir incrementando el currículum. El problema de fondo es que este criterio al peso no nos habla de la calidad ni del impacto que tiene la investigación del evaluado.

Y aquí es dónde entran las ideas de Derek de Solla Price y Eugene Garfield, que en la década de los 60 pensaron que la mejor manera de estimar la calidad de una publicación era mirar si los demás científicos se hacían eco de ella, es decir, si la citaban en sus propios trabajos. Esto tiene bastante más lógica que pesar todas las publicaciones de un investigador por igual, claramente. Así nació el campo de la bibliometría, que algunos consideran un subcampo de algo más ambicioso llamado cienciometría. Garfield creó el Institute for Scientific Information (Instituto para la Información Científica) para recopilar esta información e inventó un producto llamado Journal Citation Reports (Informes de Citas de Revistas), que de ser una buena idea y un instrumento útil acabó convirtiéndose en el origen de todos los males y, en particular, de la posición dominante de las revistas.

La cosa es que en un momento dado se empezó a considerar no sólo cuánto se citaban los trabajos de cada autor, sino qué revistas se citaban más, para clasificarlas también por su importancia, y para eso se definió algo llamado impact factor (factor de impacto), que no es más que el número de citas que reciben los artículos publicados en una revista en los dos últimos años, dividido por el número total de artículos que ha publicado, lo que viene siendo una especie de número de citas medio por artículo. Y ahí es cuando nació lo que en su día llamé el papel couché de la ciencia: el grupo selecto de revistas en el que hay que publicar para tener prestigio y opciones de acceder a buenos trabajos de investigador, y que en economía se suele llamar las top five. Y en algún momento, quizá por la proliferación de investigaciones y publicaciones, se produjo la perversión de pasar a mirar las citas de un investigador a mirar dónde publica, y a considerar que publicar en las revistas con mayor factor de impacto es el sello de calidad a tener en cuenta.

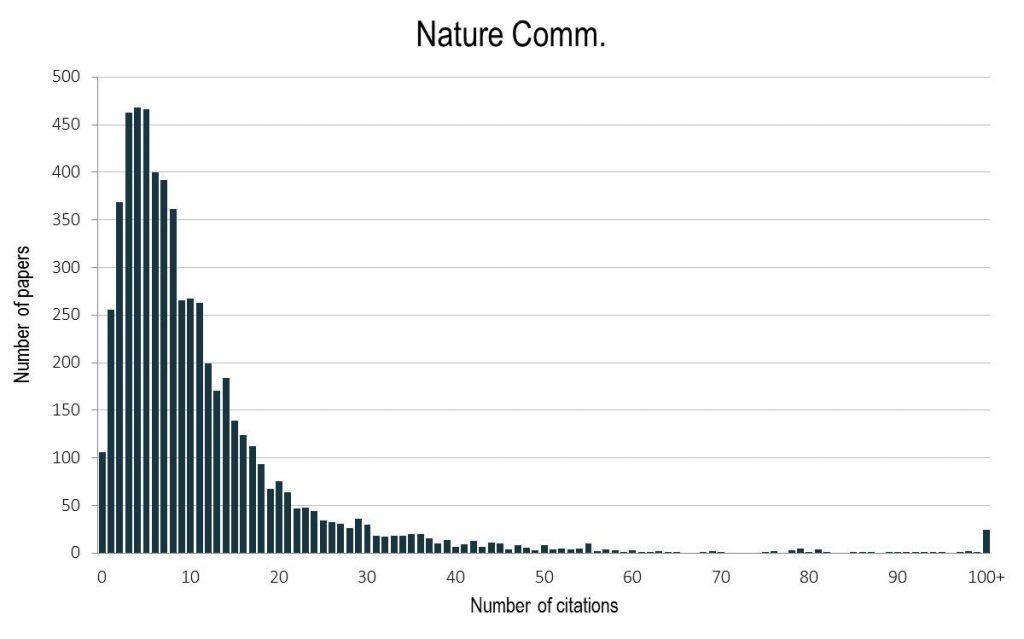

Esto es una absoluta, insisto, perversión por varios motivos (y tiene muchas consecuencias indeseadas como las que discutí en su día), pero me voy a centrar en dos de ellos. El primero es que la media de citas de una revista no quiere decir nada. Como ejemplo, pongo debajo la distribución de las citas de Nature (último factor de impacto, 40.137, uno de los más altos de todos los campos científicos), Nature Communications (último factor de impacto, 12.124) y Scientific Reports (último factor de impacto, 4.259) que he tomado de la propia Nature.

Como vemos, la mayoría de artículos no llegan ni de lejos al valor indicado por el factor de impacto, porque la distribución tiene una cola larga: hay unos pocos artículos que reciben muchísimas citas, y el resto son, por así decirlo, del montón. Así, las modas (número de citas más frecuentes) de esas distribuciones son (a ojo) 12, 5, y 1; y además, hay muchos artículos que reciben 0 citas. El factor de impacto, pues, no da una idea correcta de las citas de los artículos. Lo cual conduce directamente al segundo problema del uso del factor de impacto: que estamos valorando un artículo por el medio en que se publica, no por su valor intrínseco, y a veces la valoración será correcta, pero en general será un completo disparate. Es interesante notar aquí que las revistas con mayor factor de impacto también son las que acaban retirando más artículos incorrectos.

Como vemos, la mayoría de artículos no llegan ni de lejos al valor indicado por el factor de impacto, porque la distribución tiene una cola larga: hay unos pocos artículos que reciben muchísimas citas, y el resto son, por así decirlo, del montón. Así, las modas (número de citas más frecuentes) de esas distribuciones son (a ojo) 12, 5, y 1; y además, hay muchos artículos que reciben 0 citas. El factor de impacto, pues, no da una idea correcta de las citas de los artículos. Lo cual conduce directamente al segundo problema del uso del factor de impacto: que estamos valorando un artículo por el medio en que se publica, no por su valor intrínseco, y a veces la valoración será correcta, pero en general será un completo disparate. Es interesante notar aquí que las revistas con mayor factor de impacto también son las que acaban retirando más artículos incorrectos.

Y de todo este mundillo es de dónde sale la posición dominante de las grandes editoriales de publicaciones científicas. Primero, porque dominan la mayoría del mercado y para ser evaluado como científico hay que publicar en sus medios. Y segundo, porque tienen revistas insignia, con gran factor de impacto, en las que todos intentamos publicar para obtener prestigio y salir en los medios del gran público; si se fijan, casi todas las noticias de ciencia de la prensa se remiten a artículos de Nature, Science, PNAS, Cell o similares. Si, como sugería en mi post anterior, yo voy y dejo de publicar en revistas con factor de impacto, mi investigación deja de tener calidad, y paso a ser un paria científico. Y a mí, que tengo una carrera más que consolidada y que como funcionario puedo dedicarme a cobrar sin trabajar, me puede importar más o menos, pero la gente joven, que empieza en esto de la investigación, está totalmente cogida en este círculo vicioso y no puede escapar. Máxime cuando se usan criterios tan absurdos como los del Ministerio de Economía para evaluar las convocatorias para centros de investigación Severo Ochoa y María de Maeztu, que para identificar investigadores especialmente relevantes les piden que el 75% de sus publicaciones estén en las revistas del 25% más citado de su campo, lo cual lleva a que si uno tiene un artículo en Nature es mejor que otro que tenga 70 artículos en Nature y 30 en revistas "de medio pelo". No parece que este tipo de criterios esté realmente seleccionando la mejor ciencia, pero si quiero participar en esas convocatorias tengo que entrar en el juego y tener cuidado con donde publico. No hay que evaluar los currícula al peso, pero de ahí a que una publicación más cuente negativo, va un abismo.

Y esta es, al final, la única solución que puede tener este problema. Hablaba en mi post anterior de boicots más o menos exitosos contra ciertos grupos editoriales, o ciertas revistas, pero eso, sufrido lector, no va a ningún lado. Lo único que realmente cambiaría el juego es que todas las instituciones adoptaran la Declaración de San Francisco, más conocida por sus siglas DORA, que insta a todos los agentes del ecosistema de la investigación a abandonar prácticas de evaluación basadas en factor de impacto, y a utilizar el contenido de los resultados como verdadero criterio de selección. Obviamente, esto no nos va a hacer la vida más fácil, porque evaluar CVs exigirá hacer el esfuerzo de enterarse de qué han hecho los investigadores y que relevancia tiene para su campo, pero el hecho de que hacer algo sea difícil no es excusa para seguir haciéndolo mal. Por otro lado, esto traslada el problema de que muchísimos investigadores, cientos de miles, como dije antes, se coordinen y decidan todos a una abandonar el sistema tradicional de publicación, a otro a nivel de instituciones, unos cuantos miles, que son las que realmente tienen el poder de sacudirse y sacudirnos esta explotación de encima. Por ahora, DORA no ha sido particularmente exitosa, pero el mensaje empieza a calar, y cuántos más, investigadores y público en general, conozcamos el problema y pidamos una solución a este despilfarro y a los absurdos que conlleva, más calará. A ver si dentro de cinco años puedo escribir que ha sido así.

Nota: el día antes de aparecer este post en NeG ví este documento del INET para el G20 hablando de exactamente esto mismo en el caso de Economía, donde la posición dominante la tienen las Top 5 en colusión con algunas universidades como ya he dicho. Must read.